技术社区 来源:开源日记 2025-01-20 04:01:29 阅读:399

LocalAI是一个完全开源免费的OpenAI替代方案,它遵循OpenAI API规范,能让你在普通的消费级硬件上,无需GPU就能运行大型语言模型(LLMs)、生成图像和音频等。想想看,不用把数据上传到云端,既能保护隐私,又能省下一大笔云服务费用,是不是很香?

本地运行,数据隐私有保障

LocalAI 的最大亮点就是完全本地化运行。你不需要将数据上传到云端,所有的计算都在你的设备上完成,确保了数据的安全性和隐私性。

支持多种AI模型

无论是GPT-like的文本生成模型,还是图像分类、语音识别模型,LocalAI 都能轻松应对。它还支持多种开源模型,如LLaMA、Stable Diffusion等,满足不同场景的需求。

高度可定制

LocalAI 提供了丰富的API和插件系统,开发者可以根据自己的需求进行深度定制。你可以调整模型的参数,甚至集成到自己的应用中。

轻量级且高效

尽管功能强大,LocalAI 的设计非常轻量,能够在普通硬件上流畅运行。它还支持GPU加速,进一步提升性能。

启动LocalAI容器

仅使用CPU:

sudo docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

使用Nvidia GPU(需有Nvidia显卡及相应CUDA版本):

sudo docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

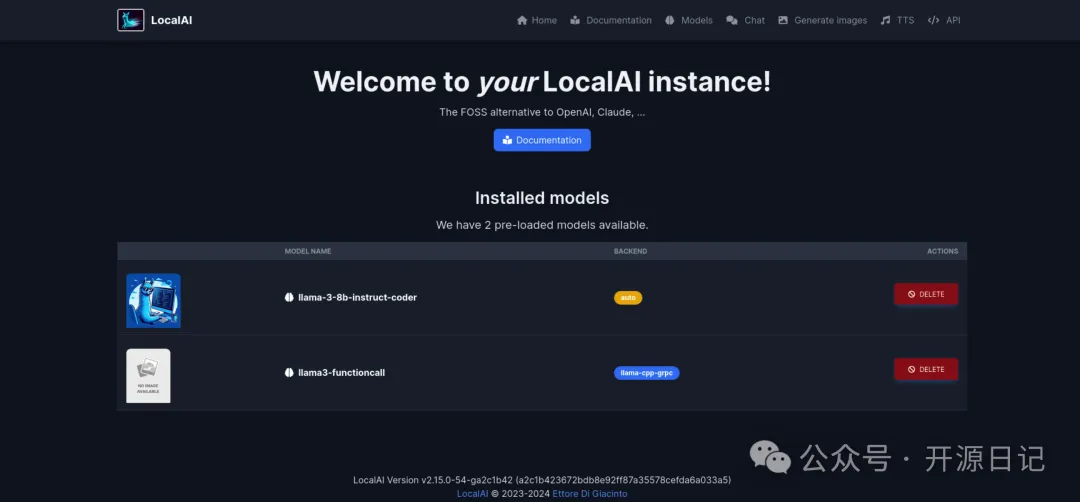

访问LocalAI Web UI

容器启动后,使用浏览器访问http://localhost:8080,即可打开LocalAI的Web UI页面。

LocalAI 不仅仅是一个工具,它代表了一种趋势——让AI技术更加平民化、本地化。无论你是开发者、研究者,还是普通用户,LocalAI 都能为你提供一个安全、灵活且高效的AI解决方案。它的开源性质也让社区能够不断推动其发展,未来潜力无限。

开源地址: https://github.com/mudler/LocalAI